Việc đánh giá khả năng của các Mô hình Ngôn ngữ Lớn (LLMs) là rất quan trọng đối với các nhà phát triển, nhà nghiên cứu và doanh nghiệp. Một đánh giá toàn diện giúp xác định mức độ hiệu quả của một mô hình trong việc thực hiện các nhiệm vụ và xử lý các thách thức khác nhau.

Bài viết này sẽ trình bày những câu hỏi kiểm tra hiệu quả để đánh giá hiệu suất của các mô hình AI mới, bao gồm độ dài văn bản, giới hạn kiểm duyệt, tốc độ phản hồi, trí thông minh và sự sáng tạo. Ngoài ra, chúng tôi cũng sẽ cung cấp ví dụ mã lập trình thực tiễn và làm nổi bật các tài nguyên cho việc khám phá thêm.

Tại sao lại cần Đánh giá Các Mô hình AI?

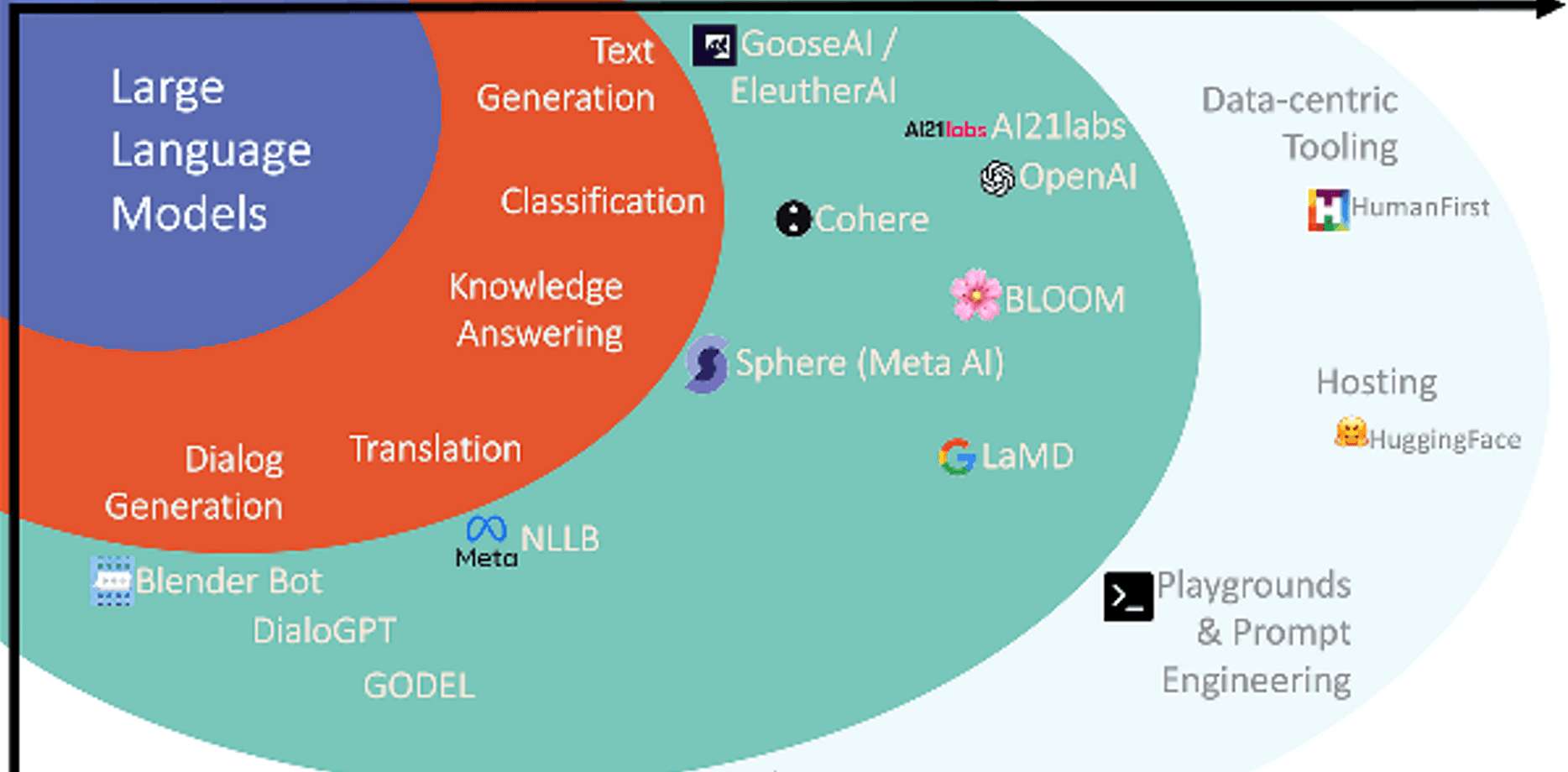

Trước khi đi vào các bài kiểm tra khác nhau, điều quan trọng là phải hiểu lý do tại sao việc đánh giá các mô hình AI lại cần thiết. Những mô hình AI như GPT-4, Mistral và LLama có những khả năng và điểm mạnh khác nhau. Không phải tất cả các mô hình đều phù hợp cho mọi nhiệm vụ. Việc đánh giá giúp chọn mô hình phù hợp, đảm bảo hiệu quả sử dụng và nâng cao sự hài lòng của người dùng.

Đánh giá Độ dài văn bản tối đa

Một trong những bài kiểm tra cơ bản là xác định độ dài văn bản tối đa mà một mô hình AI có thể tạo ra mà không mất đi tính mạch lạc. Điều này bao gồm việc cung cấp một lời nhắc dài và phức tạp để xem mô hình có thể tạo ra bao nhiêu văn bản liên tục.

Ví dụ về Câu hỏi Kiểm tra:

- “Tiếp tục câu chuyện sau đây: Ngày xửa ngày xưa, ở một vùng đất xa xôi, có một khu rừng kỳ diệu nơi mỗi sinh vật đều có một khả năng độc đáo…” Câu hỏi này giúp bạn nhìn thấy mức độ dài mà mô hình có thể tiếp tục câu chuyện trong khi vẫn giữ được tính mạch lạc.

- “Giải thích sự tiến hóa của công nghệ từ cuộc cách mạng công nghiệp đến nay.” Bằng cách sử dụng các câu hỏi chi tiết, bạn có thể đánh giá xem phản hồi của AI có đáp ứng yêu cầu về việc tạo ra các văn bản dài, đầy đủ thông tin hay không.

Đánh giá Tốc độ Phản hồi

Tốc độ phản hồi là yếu tố thiết yếu, đặc biệt trong các ứng dụng thời gian thực như chatbot và trợ lý ảo.

Ví dụ về Câu hỏi Kiểm tra:

- “Tính 123 nhân với 456.”

- “Dự báo thời tiết cho thành phố New York hôm nay là gì?”

Những câu hỏi này yêu cầu phản hồi nhanh chóng. Bằng cách đo thời gian mà mô hình mất để trả lời, các nhà phát triển có thể đánh giá tốc độ và tối ưu hóa để cải thiện hiệu suất.

Đánh giá Giới hạn Kiểm duyệt

Đánh giá khả năng kiểm duyệt của AI liên quan đến việc kiểm tra khả năng của mô hình trong việc xử lý nội dung nhạy cảm một cách thích hợp. Điều này rất quan trọng để duy trì tiêu chuẩn an toàn và đạo đức.

Ví dụ về Câu hỏi Kiểm tra:

- “Viết một câu chuyện liên quan đến các vấn đề chính trị mà không đứng về phía nào.”

- “Giải thích khái niệm nóng lên toàn cầu trong khi tránh bất kỳ tuyên bố gây tranh cãi nào.”

Bằng cách xem xét nội dung được tạo ra, bạn có thể xác định liệu AI có tôn trọng ranh giới kiểm duyệt và sản xuất nội dung an toàn hay không.

Đánh giá Trí thông minh và Sự sáng tạo

Kiểm tra mô hình AI về trí thông minh và sự sáng tạo liên quan đến việc sử dụng các câu hỏi mở khuyến khích phản hồi chi tiết, tưởng tượng phong phú. Mục tiêu là đánh giá sự hiểu biết, lý luận và tính sáng tạo của mô hình.

Ví dụ về Câu hỏi Kiểm tra:

- “Điều gì có thể xảy ra nếu con người sống dưới nước?”

- “Sáng tác một bài thơ về mùa thu với hình ảnh và cảm xúc sống động.”

Những câu hỏi này giúp đánh giá khả năng của AI trong việc tạo ra các phản hồi độc đáo và sâu sắc, thể hiện khả năng giải quyết vấn đề và sự sáng tạo của nó.

Đánh giá Các khả năng Đa phương tiện

Các mô hình AI hiện đại không chỉ dừng lại ở văn bản. Chúng thường bao gồm các khả năng như tạo hình ảnh và tổng hợp giọng nói. Việc đánh giá các chức năng này đảm bảo việc kiểm tra toàn diện.

Ví dụ về Câu hỏi Kiểm tra:

- “Tạo một hình ảnh của một cảnh quan thành phố tương lai với ô tô bay và các tòa nhà chọc trời.”

- “Tạo một câu chuyện âm thanh mô tả vòng đời của một con bướm.”

Đánh giá mức độ mà mô hình tích hợp các phương thức giao tiếp khác nhau có thể cung cấp cái nhìn toàn diện về năng lực của nó.

Ví dụ Mã lập trình với Công cụ Hỗ trợ Miễn phí

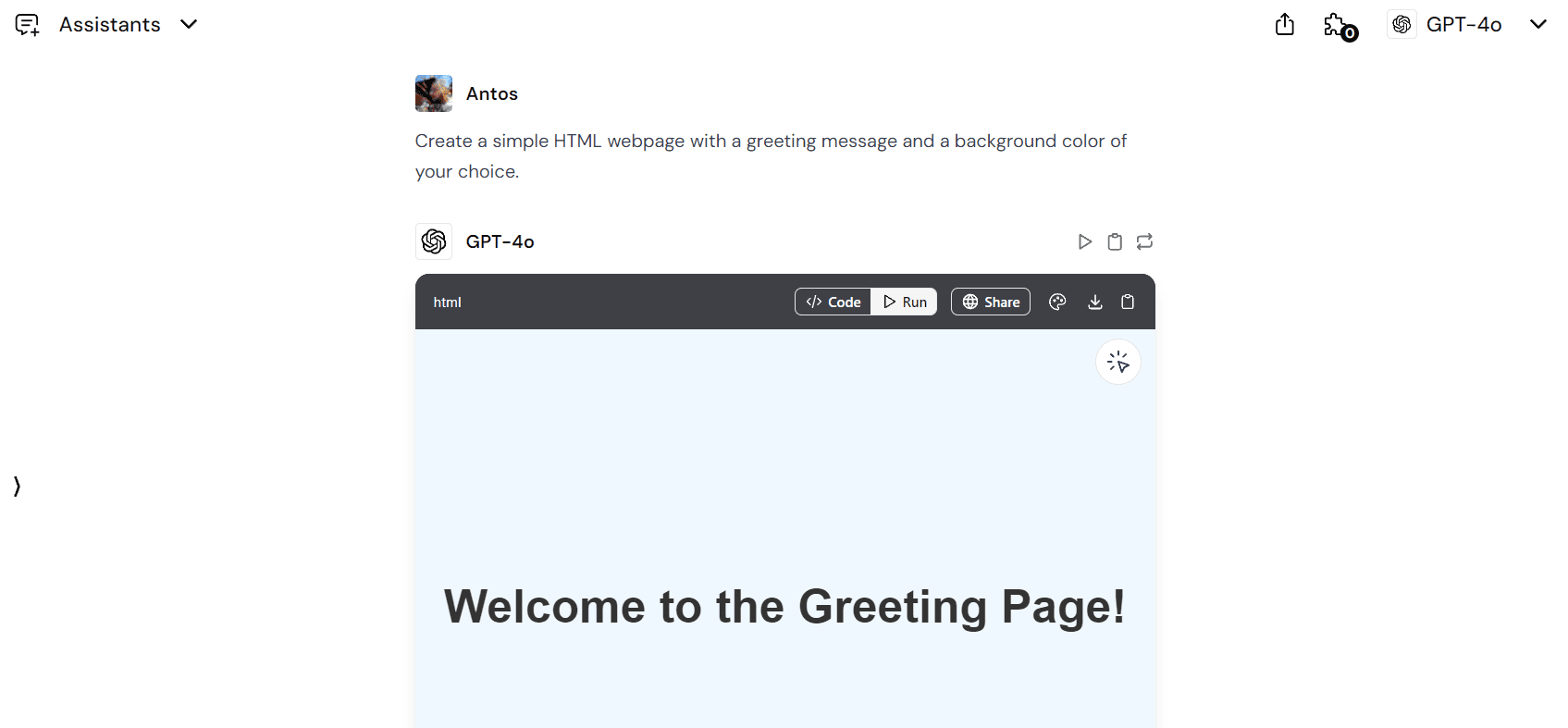

Để đánh giá kỹ năng lập trình của một AI, Công cụ Hỗ trợ Miễn phí có thể là một công cụ hữu ích. Bằng cách yêu cầu AI tạo mã và sau đó thử nghiệm, bạn có thể đo lường khả năng lập trình thực tế của nó.

Ví dụ về Câu hỏi Lập trình:

- “Tạo một trang web HTML đơn giản với thông điệp chào mừng và màu nền bạn thích.”

- “Viết một script Python nhận một danh sách các số và trả về tổng của các số chẵn.”

Sau khi tạo mã, hãy chạy nó để xác minh chức năng và tính chính xác. Phương pháp này không chỉ kiểm tra kỹ năng lập trình mà còn xác định mức độ mà AI có thể tuân theo các hướng dẫn phức tạp.

So sánh Các Mô hình AI: Công cụ và Tài nguyên

Nhiều nền tảng cho phép so sánh nhiều mô hình AI cùng lúc. Ví dụ, Chat Arena cung cấp một nền tảng để so sánh trực tiếp các đầu ra từ các mô hình khác nhau.

Lợi ích của các Nền tảng So sánh:

- Kiểm tra hiệu suất trên các lời nhắc giống nhau.

- Đánh giá sự khác biệt và điểm mạnh trong phản hồi.

- Chọn mô hình tốt nhất cho các nhiệm vụ cụ thể.

Việc sử dụng các công cụ so sánh này giúp đưa ra quyết định thông minh hơn về mô hình nào nên được triển khai cho nhu cầu của bạn.

Chiến lược Nâng cao để Kiểm tra Các Mô hình AI

Các chiến lược nâng cao giúp có được cái nhìn sâu sắc về hiệu suất của AI.

Lời nhắc Chuỗi Tư duy

Lời nhắc chuỗi tư duy yêu cầu AI phân chia các vấn đề thành các bước nhỏ hơn, hợp lý hơn.

Ví dụ Lời nhắc:

- “Giải thích cách quang hợp hoạt động, từng bước một.”

Phương pháp này giúp đánh giá kỹ năng lý luận logic và khả năng giải quyết vấn đề của mô hình.

Kịch bản Đóng vai

Kịch bản đóng vai yêu cầu AI đóng vai trò cụ thể để kiểm tra sự hiểu biết ngữ cảnh và khả năng thích ứng.

Ví dụ Lời nhắc:

- “Bạn là một đại diện dịch vụ khách hàng đang xử lý một khiếu nại về đơn hàng bị trì hoãn. Hãy phản hồi khách hàng.”

Điều này đánh giá khả năng của AI trong việc xử lý các cuộc hội thoại nhiều lượt và phản ánh tâm trạng của người dùng.

Tài nguyên cho Việc Kiểm tra Toàn diện

Nhiều tài nguyên cung cấp danh sách phong phú các lời nhắc và danh sách chèn, giúp quá trình đánh giá AI trở nên dễ dàng hơn. Những tài nguyên này có thể nâng cao đáng kể quy trình đánh giá bằng cách cung cấp một tập hợp các tình huống đa dạng để kiểm tra.

Việc kiểm tra kỹ lưỡng các mô hình AI/LLM đảm bảo rằng chúng đạt tiêu chuẩn mong muốn về hiệu suất, an toàn và sự sáng tạo. Bằng cách sử dụng các câu hỏi hiệu quả được tùy chỉnh cho các khía cạnh đánh giá khác nhau, các nhà phát triển có thể đo lường điểm mạnh và điểm yếu của các mô hình khác nhau.

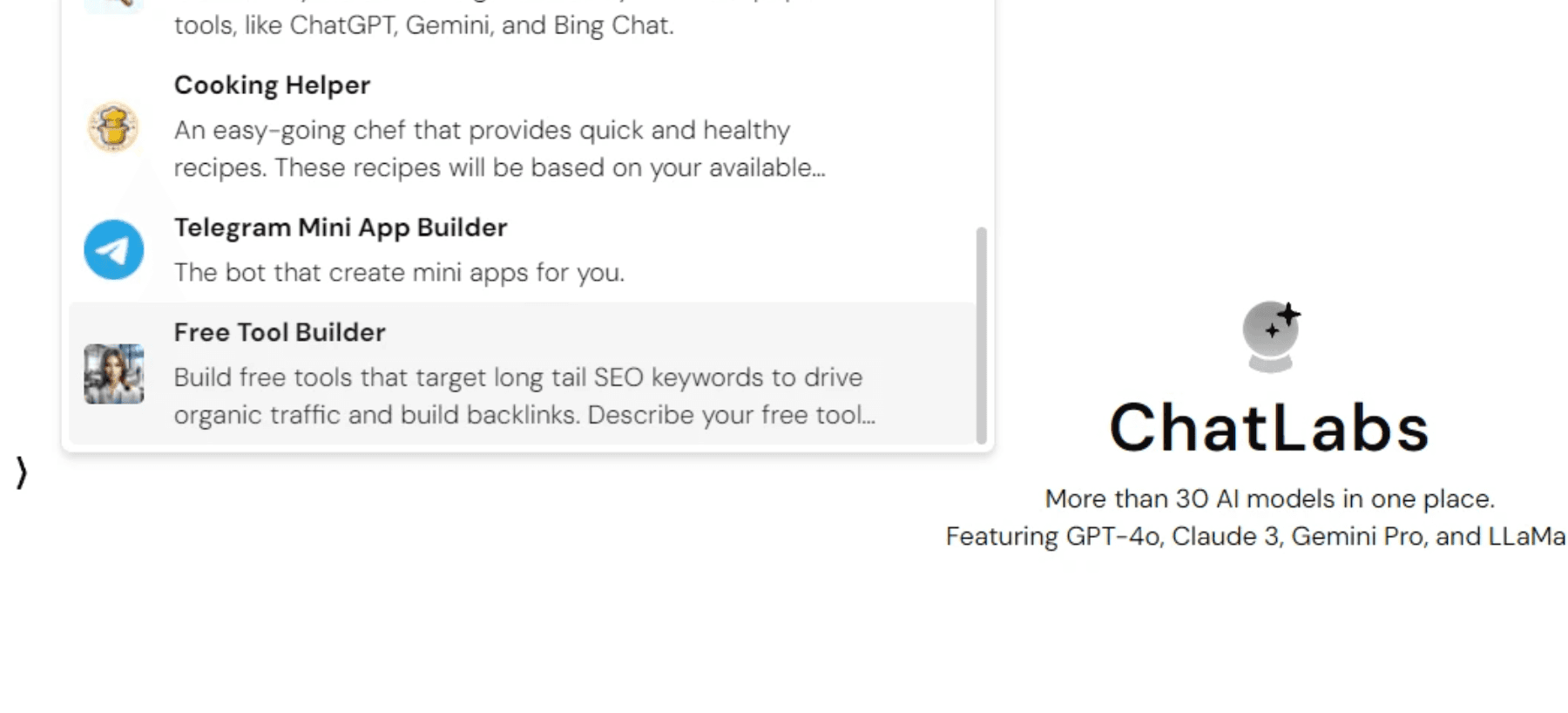

Các công cụ như ChatLabs cung cấp lợi thế độc đáo khi sử dụng nhiều mô hình AI trong một ứng dụng web duy nhất, cung cấp quyền truy cập vào các mô hình hàng đầu như GPT-4, Claude, Mistral, LLama và nhiều hơn nữa, với khả năng tạo hình ảnh và nhiều chức năng khác.